更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

Web数据抓取服务介绍

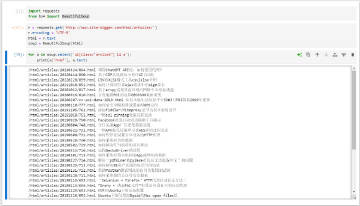

因特网(Internet)是一个巨大的和飞速发展的信息资源,但大多数信息都是以无结构的文本形式存在,使得信息聚合非常困难。 Web数据抓取是一个从目标网页中摘取某些数据形成统一的本地数据库的一个过程,这个过程所需要的不仅仅是网页爬行器(爬虫)与网页解析器(HTML解析器)。一个复杂的数据抽取过程需要应付种种障碍,例如会话识别,HTML表单,客户端脚本,并发连接限制,以及数据整合问题等等。

由于目标网站结构复杂多样,客户需要各异,因此任何数据采集软件都不可能完全满足所有用户的需要。我们针对不同的网站、不同客户的需求定制抓取程序,最终为客户提供完整并且准确的数据或脚本。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

我们服务的内容

我们提供Web数据抓取相关的服务:

- 网站数据定制采集服务(存储为CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等)

- 移动App数据定制采集服务(采集App内展示的数据)

- 定制开发数据采集程序(例如,自动数据导出、表单提交、报表生成等等)

Web数据抓取服务是采集网页数据的最简便方法,别再把时间浪费在人工的复制与粘贴上了。我们用专业、科学、快捷的方法采集到数据后,会进行数据处理,然后存储为您想要的格式。

我们做什么? -- 我们从您的目标网页上抽取需要的数据,然后把原始数据转化成结构化的数据。我们通过专业、科学的方法保证抓取数据的数量和质量。

您得到的是什么? -- 你得到的是完整而准确的数据。数据文件格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MySQL等等。

工作的是如何进行的? -- 您需要告诉我们您的目标网站的网址,和您所感兴趣的内容,我们会据此分析网站的结构和数据抓取的复杂度,确定目标网站是否可供挖掘;然后针对性地为抓取静态或动态网页上的数据而设计相应的抓取程序,用来分析网页、下载数据、解析数据、结构化存储等等;最后我们会以您需要的格式交付。

更多常见问题请参阅我们的FAQ页面,点击进入。

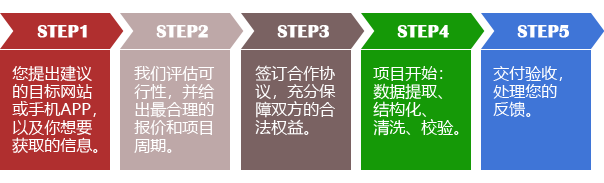

我们服务的流程

我们服务的优点

简单: 您不需要使用任何的软件,只需要告诉我们您的目标网站和你感兴趣的内容,就能获取我们为您抓取的数据。

弹性: 您能从任何的网站上获取任何数据,特别是动态网站上的数据。

快捷: 对于一个需要20个人工作日完成的工作,我们能在数小时内完成。因此,您不仅能节省您的时间、精力和金钱,还能让您领先于您的竞争对手。

精确: 抽取结果的每一列都是您所需要的,不多也不少。我们会按照您的要求对数据进行过滤和校验。

低价: 您可以节省无法以金钱来计量的时间和精力,以及数倍于所付费用的人工和设备投入!