更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

什么是Web数据抓取(采集)?

因特网(Internet)中有海量的有用数据,但大多数信息都是以无结构的文本形式存在,使得信息聚合和重用非常困难。 Web数据抓取(采集)是一种将非结构化内容转换为结构化数据(例如,Excel文档、MySQL数据库)的技术。一个Web数据抓取(采集)项目大致可以分为如下三步:

1)爬取目标网站并下载相关页面。

2)从下载的页面中提取感兴趣的数据(字段,例如 名称、地址)。

3)将提取的数据(字段)以结构化的形式存储(例如,CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MySQL)。

数据采集合法吗?

从公共网站上采集数据是很常见的(实际上,“谷歌”、“百度”的数据也来源于采集)和合法的。我们进行采集的前提是假设客户将会合法、合理地使用数据,并且客户已获取目标数据源的访问授权。同时我们保留权利拒绝任何人将数据用于非法目的或我们认为不合理的用途。

你们能采集什么样的数据?

任何你能在浏览器中看到的数据都可以被抓取,只是难度会有所不同。以下几点因素会使得采集工作变得困难,从而费用也将更高。

■ 限制单个IP的访问数量或访问频率。

■ 不一致的页面结构。

■ 数据被加密(或混淆)了,需要解析。

■ 数据被JavaScript动态加载。

■ 数据在Flash中展现。

■ 海量的数据(例如,数百万甚至上千万的页面)。

你们的采集服务比用采集工具自己采集有什么优势?

采集工具具有局限性:

■ 很多场景都不能适用。比如,登录采集、Ajax动态加载数据、联合采集、需要上下文逻辑、数据加密等等。

■ 操作上具很大的难度。要求客户能够自己分析网站和页面结构,客户通常需要自己编写复杂的提取规则。

■ 不能对采集结果的二次处理。

我们提供的是定制采集服务,即根据目标网站的实际情况以及客户的需求,编写采集脚本,能够处理各种复杂的情况(数据加密、连接限制)和上下文逻辑,从而能够得到最完美的采集结果。

成人网站你们是否采集?

不。任何反动、色情、博彩性质的网站我们都拒绝采集。

怎么收费?

费用主要取决于目标网站的复杂程度,点击这里查看我们的基本收费标准。如果一个网站规模较小、结构良好、数据在HTML中清晰可见,我们的收费应该在1500元以内。

我们也出售一些采集好的数据,价格会比定制采集的费用少很多。点击进入数据超市,查看我们的部分数据。

采集一个网站需要多长时间?

时间主要取决于目标网站的规模,一个简单的网站可能在一天内即可采集完成,但是一个大的网站可能会耗费数周的时间。在项目开始之前我们会给你一个估计时间。我们采用分布式系统架构,日采集页面数可以达到8000万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效绕过各种反采集策略。

怎么雇用你们?

你只需要在这里提交你的项目,我们会在24小时内跟你取得联系。你也可以通过电话或者在线QQ直接联系我们,点击这里查看我们的联系方式。

怎么付款?

在项目的开始,我们会收取项目总额30%的预付款,交付数据时结算尾款。

我们支持多种支付途径:支付宝、银行汇款、PayPal,详情请查看这里。

能退款吗?

我们的退款原则是:

■ 如果一个项目无法完成当然是无条件退款。

■ 如果在我们开始开发前你想取消一个项目,你也可以得到退款。

■ 如果你的需求在项目开始之后变化了,我们可以重新谈价格。

你们使用什么技术?

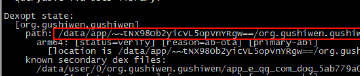

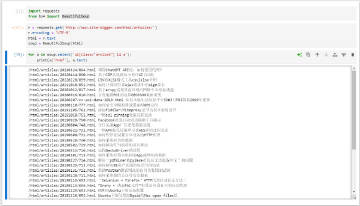

■ 我们的数据采集程序主要采用开源、免费、跨平台并支持多线程的Python语言开发。

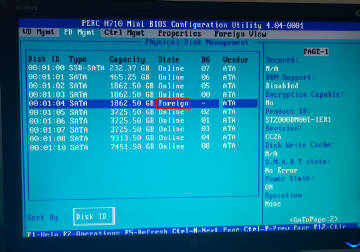

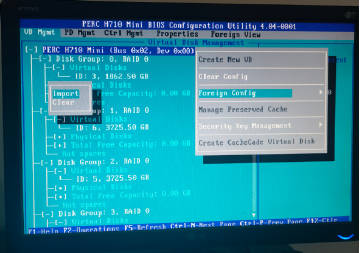

■ 对于大型采集项目我们采用亚马逊云主机。我们同时在西安电信,Linode东京机房托管和租用了多台主机。

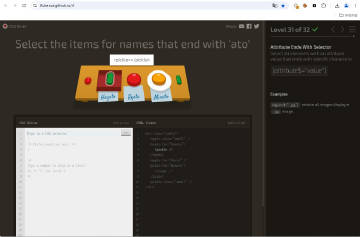

■ 解析JavaScript(例如加密)我们采用Webkit技术。

■ 我们也熟悉其它开发语言:PHP。

你们招聘开发人员吗?

如果你对Web数据采集技术感兴趣,如果你想通过挑战各种难题学到新技术,我们很乐意收到你的简历hello@site-digger.com。