更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

数据说明

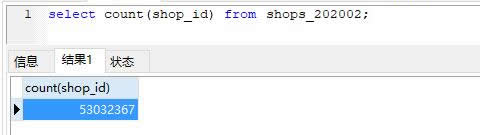

知名本地生活信息平台各品类商户数据,本次共采集到超过5303万条(53032367条,总数统计如下图所示)。 2019年6月-2020年1月采集。

PS:仅商户基本信息数据,不含评论列表数据。

更新说明

1.本轮共采集到了5303万条不重复的POI数据。PS:使用shop_id作为主键,没有重复。

2.本轮更新开始于2019年6月中旬,完成于2020年1月中旬,耗时近7个月。

3.数据涵盖美食、休闲娱乐、丽人、酒店、亲子、景点、运动健身、购物、家装、教育培训、生活服务、医疗健康、爱车、宠物、结婚等15大类。

各分类数据量如下:

美食 15408473

丽人 3465759

酒店 1080155

亲子 1357050

景点 250719

运动健身 300395

购物 10171669

家装 5077941

教育培训 1535670

生活服务 6691821

休闲娱乐 1750485

医疗健康 1760787

宠物 154696

爱车 2965910

结婚 755022

其它 305815

4. 数据覆盖全国约400个城市,不含境外城市。点击这里查看各城市店铺数量统计。

5. 本次采集首先对2018年6月份的采集版本(4794万)做了全量完整更新。同时通过遍历POI列表又新采集到509万新增的POI。

6. 本版本5303万商户POI数据中:

■状态为"在营业"的有34076224条;

■状态为"关闭"的有18512495条;

■状态为"尚未营业"的有151144条;

■状态为"暂停营业"的有284907条;

■状态为"网友提交"的公共信息7597条。

PS:关闭的店铺在源网站上仍将可以打开,页面会有标志"商户已关"。

7. 其中有电话号码的28634002家(约占总数据量的54%)。

8. 本次采集的是APP数据源,2018年6月之前均采集的是PC版数据源。因此字段有所调整,例如少了"good_remarks"(好评数)和"bad_remarks"(差评数)字段。

字段说明

数据格式

数据格式:CSV和MySQL。

字符编码:UTF-8。

文件大小:RAR压缩后3.41GB,解压后约20GB。

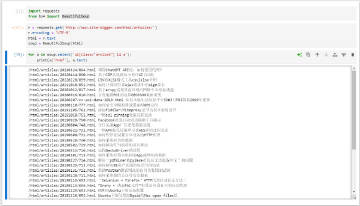

示例数据

点击查看:http://db.site-digger.com/csv/6469616e70696e675f73686f70735f3230313930362d3230323030325f76335f757466385f73616d706c655f31303030/

温馨提示:为了保护个人隐私,示例数据中的手机号码隐藏了中间4位。