更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

为了进行本次实验,我们用树莓派3B+(如下图所示)搭建了一个无线网关。

我们给树莓派安装了Ubuntu18.04系统。树莓派3B+有一个千兆网口并搭载一个支持AP功能的无线网卡。

有线网卡eth0,IP配置为192.168.1.11; 无线网卡wlan0,IP配置为: 10.10.1.1;

无线网卡以AP模式工作,通过hostapd创建热点,使用isc-dhcp-server作为DHCP服务器。

准备工作:

1.开启Linux的内核IP转发功能

或者

sudo bash -c "echo 1 > /proc/sys/net/ipv4/ip_forward"

前者重启失效,后者重启仍有效

2.给防火墙添加自动SNAT规则

至此,无线路由器(下简称树莓派)已配置到位。

用笔记本的无线网卡连接上AP,获取到的IP地址为10.10.1.52,测试网络工作正常。本次实验的网络环境如下图所示。

另外,台式机192.168.1.6是笔者当前使用的电脑。

实验一:HTTP截流并转发给Natcat

实验目的:

截获内网发出的HTTP流量,并转发给Natcat(下简称nc)处理。

实验步骤:

1.在树莓派上用nc监听8080端口,并将nc.txt的内容回送给客户端,即模拟一个HTTP服务端,命令如下。

nc.txt的内容如下(一个最简化HTTP响应报文):

Content-Length: 2

hi

2.在树莓派上加入如下DNAT规则。将所有目标端口为80端口(HTTP)的请求重定向到10.10.1.1:8080(即nc监听的端口)。

3.在笔记本(10.10.1.52)上启动Wireshark抓包。

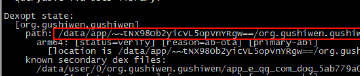

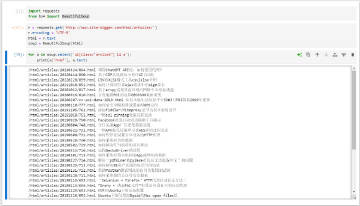

4.然后打开浏览器并访问一个HTTP网站(注意不能是HTTPS网站,因为我们只转发了80端口的流量,而没有转发443端口的流量),例如在浏览器地址栏输入http://www.site-digger.com/html/about.html。按下回车键瞬间,nc接收到了该HTTP请求,数据如下图所示。

5.同时浏览器上显示出了内容"hi"。Wiireshark也抓到了2条HTTP协议数据,如下所示。

第一条为HTTP请求(10.10.1.52:56506 -> 47.90.32.133:80)包,如下图所示:

第二条为HTTP应答(47.90.32.133:80 -> 10.10.1.52:56506),如下图所示:

实验总结:

1.实际上该HTTP请求并未真正发送到了目标主机www.site-digger.com(47.90.32.133:80),而是在树莓派路由器内被拦截并重定向给了nc进程;

2.来自www.site-digger.com(47.90.32.133:80)的应答数据实际上也并非真正来自目标网站,而是来自于路由器上的nc进程;

实际的数据包发送流程是这样:

HTTP请求【浏览器(10.10.1.52:56506) -> www.site-digger.com(47.90.32.133:80)】包到达树莓派路由器内核后被我们配置的NAT规则命中,内核修改包为【浏览器(10.10.1.52:56506) -> nc进程(10.10.1.1:8080)】,并记录下原始的映射关系。这样nc进程就收到了该HTTP请求,nc做出应答之后数据包是这样的【nc进程(10.10.1.1:8080)->浏览器(10.10.1.52:56506)】,数据包到内核之后会根据之前保存下来的映射关系,再将包修改为【 www.site-digger.com(47.90.32.133:80) ->浏览器(10.10.1.52:56506)】,这样浏览器顺利接收到HTTP应答(可怜的浏览器并不知道该响应是伪造的)。

实验二:HTTP截流并转发给互联网远程WEB主机

在实验一中我们是把80端口的流量转发给了本地主机(路由器上的nc进程),那么如果是转发给互联网上的远程主机,是否能正常工作呢?

1.在树莓派上加入如下DNAT规则。将所有目标端口为80的请求重定向到47.90.32.133:80(鲲之鹏的Web服务器)。

2.我们在笔记本浏览器中尝试访问一些HTTP网站,发现无论我们输入什么网址,返回的内容都是http://47.90.32.133/(Apache默认首页),如下截图所示(访问www.qq.com)。

结论:DNAT也可以转发流量到远程主机。

实验三:HTTP + HTTPS截流并转发给Mitmproxy

激动人心的时刻就要来了,实验三才是我们本次研究的终极目标。资深爬虫开发人员肯定对Mitmproxy不陌生,它通过中间人代理模式工作,即能处理HTTP协议数据,又能通过伪造证书解析HTTPS协议数据。由于Mitmproxy是通过代理模式工作的,我们要抓包必须要先给浏览器或者手机的WIFI设置Fiddler代理。但是这个步骤很繁琐,特别对手机而言,每次都要要输入一遍参数,测完还要再去掉代理。况且还有些设备你无法给它设置代理,例如小米音响。

本次实验的目标是打造一个自动化HTTP(S)抓包路由器,只要我们的设备(PC、手机、平板、或者其它支持WIFI连接的智能设备)连上该路由器热点,就能自动抓取设备发出的HTTP(S)流量并解析。

实验步骤:

1.在树莓派上安装mitmproxy,安装完成之后,以透明代理(Transparent Proxying)模式启动。

# 安装mitmproxy sudo pip3 install mitmproxy # 以Transparent模式启动mitmweb mitmweb --mode transparent --showhost

启动后,如下图所示:

由于mitmweb提供的数据包查看接口(WEB版的)默认只监听127.0.0.1:8081,因此我们要想在远程主机上查看还得添加一条如下的DNAT规则,使得我们能够远程访问该接口。

sudo iptables -t nat -A PREROUTING -p tcp --dport 8081 -j DNAT --to 127.0.0.1:8081 # 默认系统不转发127.0.0.1,需要如下配置上述规则才能起作用 sysctl -w net.ipv4.conf.eth0.route_localnet=1

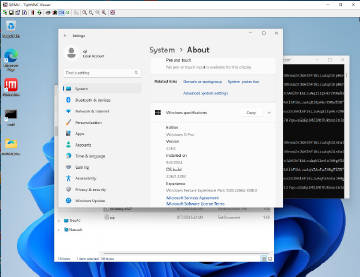

上述步骤完成之后,我们可以在远程主机比如192.168.1.6上访问一下http://192.168.1.11:8081 试试,如下所示:

2.在树莓派上加入如下DNAT规则。将所有目标端口为80或者443的请求重定向到10.10.1.1:8080(树莓派上mitmproxy监听的端口)。

sudo iptables -t nat -A PREROUTING -p tcp --dport 80 -j DNAT --to 10.10.1.1:8080 sudo iptables -t nat -A PREROUTING -p tcp --dport 443 -j DNAT --to 10.10.1.1:8080

添加成功之后可以看到nat表的规则如下:sudo iptables -t nat -L

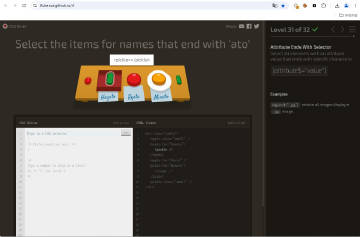

3.手机连接树莓派的热点,先用浏览器访问http://mitm.it 下载并安装根证书。然后打开一个微信小程序,比如打开58同城小程序,查看发布信息的电话号码。查看mitmproxy上是否抓取到了该数据包。如下图所示,成功抓取。

好了。至此我们的抓包利器打造完毕。今后只要我们把设备接入该WIFI,就能抓取并分析设备发出的HTTP(S)数据。需要注意的这里我们不能使用Fiddler来替代Mitmproxy,因为Fiddler不支持Transparent Proxying模式。因为我们转发的是原始HTTP请求,而不是HTTP代理协议请求。

参考文章:

https://mitmproxy.readthedocs.io/en/v2.0.2/tutorials/transparent-dhcp.html

http://www.zsythink.net/archives/1764