更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

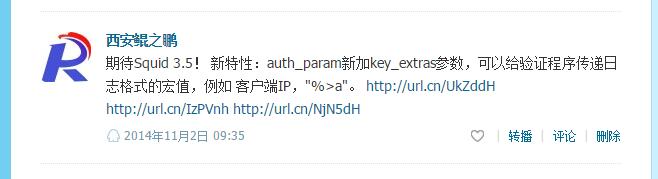

我在14年11月份的时候(如下图)就注意到Squid将在3.5版本增加一个新特征:auth_param将增加一个新的参数“key_extras”,使用这个参数可以向验证程序动态传递额外的参数(之前默认只能动态传递用户名和密码)。

转眼快2年过去了,期间也部署过很多次的Squid,由于使用都是Ubuntu的系统,默认源里面一直都还是3.3.8版本,用着也一直很稳定。最近支付宝的一个兄弟问到我3.5版本早都出来了,为啥你不升级,我才想起来其实我一直就在期待3.5这个版本的新特性,只是后来给忘了。

目前Squid 3.5.22是最新版本,在Squid 3.5(http://wiki.squid-cache.org/Squid-3.5)的新特性介绍里第二条就提到了“Authentication helper query extensions: New auth_param parameter key_extras to send additional parameters to the authentication helper.”。

这“额外的key_extras参数”包括的范围很广,文档(http://www.squid-cache.org/Doc/config/auth_param/)说到"In theory, any logformat %macro can be used."(理论上讲,所有日志格式宏都可以被使用),日志格式宏这里有一个列表:http://devel.squid-cache.org/customlog/logformat.html,例如 %>a表示客户端IP, %la表示服务器端IP(也就是客户连接的代理的IP)。

有了这些额外参数我们就可以在认证脚本中实现一些高级的功能,比如限制某个用户只能使用服务器上特定的一些IP(考虑多IP服务器),再比如限制不同等级用户的访问频率。

我们可以利用Squid的auth_param basic program来设置一个自定义的认证后端程序(来替代我们常用的basic_ncsa_auth)。如何编写这样一个程序或者说认证脚本工作流程是什么样的呢?这在squid.conf的注释里面就有介绍:

# TAG: auth_param

......

# "program" cmdline

# Specify the command for the external authenticator. Such a program

# reads a line containing "username password" and replies "OK" or

# "ERR" in an endless loop. "ERR" responses may optionally be followed

# by a error description available as %m in the returned error page.

# If you use an authenticator, make sure you have 1 acl of type

# proxy_auth.

认证程序从标准输入中读取一行内容,从这一行中提取用户名和密码,并判断用户名密码是否有效,如果有效输出OK,如果无效输出ERR,如此无限循环。工作流程很简单。

我们可以看到默认认证程序只能动态的获取到用户名和密码两个参数。利用Squid3.5 auth_param新增的key_extras参数就可以向认证脚本动态传递更多的参数,应该怎么来设置key_extras参数呢,根据文档的说明(http://www.squid-cache.org/Doc/config/auth_param/)和我自己的多次实验终于成功了,完整配置行如下:

auth_param basic program /usr/bin/python /etc/squid/squid_auth_helper.py auth_param basic key_extras "%>a %la" auth_param basic realm IPRENT.CN Proxy Auth Required acl auth_users proxy_auth REQUIRED http_access allow auth_users

注意:key_extras的值要用双引号包住("Quoted" format),否则只能传递进去一个参数。

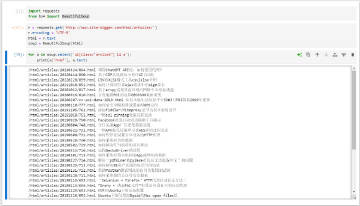

下面附上一个用Python实现的最简功能认证脚本,你可以在这个模板基础上实现更高级的功能。

# coding: utf-8

# squid_auth_helper.py

# Author: redice(qi@site-digger.com)

# Created at: 2016-10-12

# Python版本的Squid3.5权限认证脚本模板

# 在squid.conf中的"htcp_access deny all"之前加入如下配置:

# auth_param basic program /usr/bin/python /etc/squid/squid_auth_helper.py

# auth_param basic key_extras "%>a %la"

# auth_param basic realm IPRENT.CN Proxy Auth Required

# acl auth_users proxy_auth REQUIRED

# http_access allow auth_users

# 上面第二行的功能是将“客户端IP”和“服务端IP”作为命令行参数传递给认证脚本。支持更多宏格式http://devel.squid-cache.org/customlog/logformat.html

# key_extras是Squid3.5版本添加的新特性(老版本不支持),详见http://wiki.squid-cache.org/Squid-3.5

import sys

import logging

# 记录日志

# sudo chmod 755 /var/log/squid/squid_auth_helper.log

# sudo chown proxy:proxy /var/log/squid/squid_auth_helper.log

logging.basicConfig(level=logging.DEBUG,

format='%(asctime)s %(levelname)s %(message)s',

filename='/var/log/squid/squid_auth_helper.log', filemode='a')

def matchpasswd(username, password, client_ip, local_ip):

"""检测是否有权限访问

"""

logging.info('New auth request: username = {}, password = {}, client_ip = {}, local_ip = {}'.format(username, password, client_ip, local_ip))

# 这里仅实现了一个最简单的判断。你可以结合数据库实现复杂的认证逻辑。

# 可以根据client_ip和local_ip做一些高级的限制,比如限制一个账号只能使用服务器上的某些IP(考虑多IP服务器情况)。

if username == 'test' and password == 'iprent.cn':

return True

return False

if __name__ == '__main__':

while True:

# 从stdin读取一行

line = sys.stdin.readline()

# 提取username, password, client ip, local ip参数

username, password, client_ip, local_ip = line.split()

# 判断是否有权限

if matchpasswd(username, password, client_ip, local_ip):

sys.stdout.write('OK\n')

else:

sys.stdout.write('ERR\n')

# 输出

sys.stdout.flush()

同时,我把代码也放到了Bitbucket: https://bitbucket.org/snippets/kunzhipeng/RgdKb

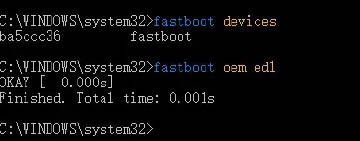

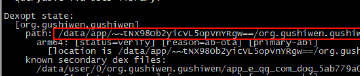

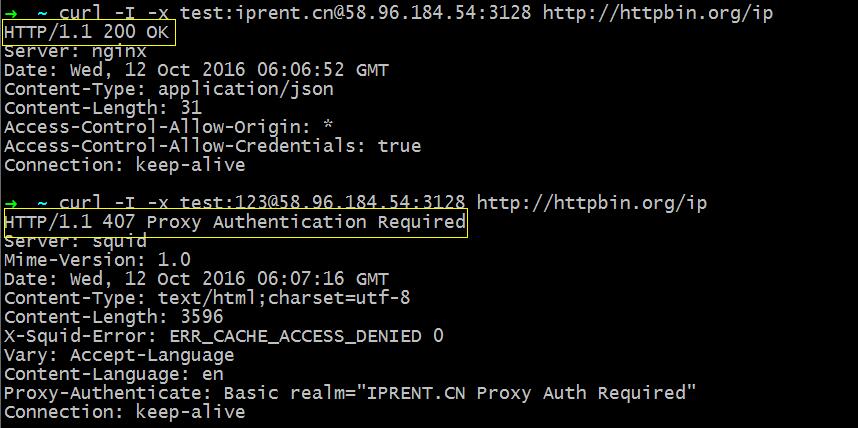

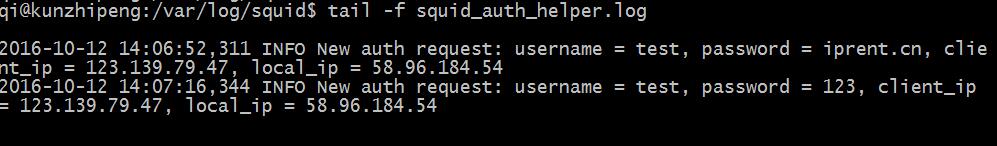

测试结果截图:

第一次使用一个正确的密码,第二次使用一个错误的密码,查看返回结果以及后台脚本输出的日志信息。

最后补充一点Squid3.5的安装,由于Ubuntu(我用的14.04版本)默认源里的Squid还是3.3.8版本,因此只能编译安装3.5.22版本。过程稍微有点复杂,网上找到一文章介绍的比较详细:https://agratitudesign.blogspot.com/2015/05/building-squid-354-transparent-proxy-on.html (赞一个)。如果你是用在产品服务器上建议你编译的时候将--with-maxfd(最大可打开文件数)参数的值修改大一些,文章中使用的是--with-maxfd=8192,这个不够用。