更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

更多>>官方微博

-

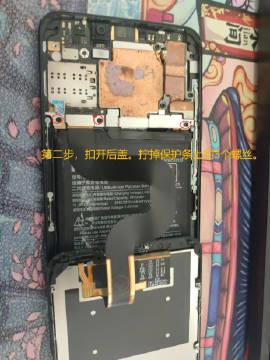

【经验分享】已解锁BL的手机进9008模式

高通9008模式全称"Qualcomm HS-USB QDLoader 9008",它相对于recovery、fastboot和Android系统是独立的。即深刷模式,也叫EDL,号称"救砖神奇"。

对于已解锁BL的手机,进入9008相对比较简单,以小米Mi6X为例:

1. 先确定手机是否解锁BL了。已解锁BL的手机,刚开机的时候会有"Unlocked"字样,如附图1所示。

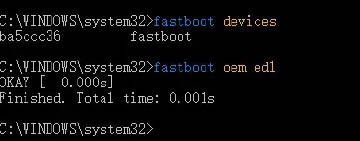

2. 长按“音量减键 + 开机键”进入fastboot。

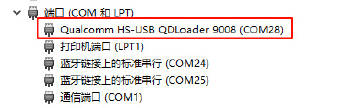

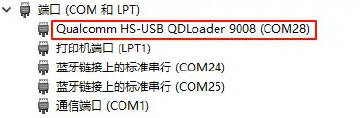

3. 执行fastboot oem edl,即可进入9008模式,进入成功后设备管理器COM端口里可以看到"Qualcomm HS-USB QDLoader 9008"。如附图2、3所示。

发布时间:2024-11-26 12:53:03

-

【经验分享】com.android.org.conscrypt.TrustManagerImpl证书固定检测绕过示例

某APP使用通用的sslunpinning脚本后仍然抓不到包:

(1)分析logcat日志,发现com.android.org.conscrypt.TrustManagerImpl类相关代码抛出java.security.cert.CertificateException异常,如图1所示。

(2)hook 类com.android.org.conscrypt.TrustManagerImpl的checkTrusted和checkServerTrusted方法,返回空列表,成功抓到包。

日志线索寻找关键词:CertificateException、CertificateExpiredExceptio、SSLHandshakeException

发布时间:2024-10-24 15:36:45

-

【经验分享】如何获取安卓手机上已安装APP的安装包(.apk)文件?

1. 先查看已安装APP列表,确定对应APP的包名。

adb shell pm list packages

2. 假设包名为org.gushiwen.gushiwen。再根据包名查看APP的详细信息:

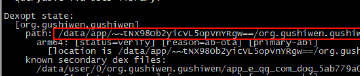

adb shell dumpsys package org.gushiwen.gushiwen

返回信息中的path属性,以base.apk结尾的,即就是这个APP的安装文件,如附图1所示。另外返回的信息中还有当前APP的版本(versionName属性),如附图2所示。

3. pull下来这个文件,就可以在其它设备上安装了。

发布时间:2024-10-22 11:27:51

-

【经验分享】Dell R720意外断电重启之后丢失硬盘(硬盘状态变为Foreign)问题解决?

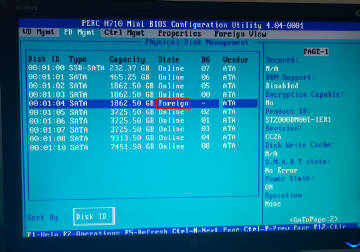

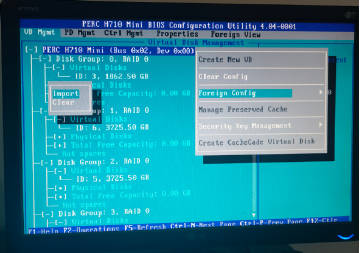

本来有10块盘,启动的时候显示只有9块Virtual Disk。“Ctrl + R”进入RAID设置,在“VD Mgmt”标签页下也只看到了9块Virtual Disk。在“PD Mgmt”标签页下看到是有10块物理盘,不过第5块状态变成“Foreign”了(如附图1所示)。

解决方法:在“VD Mgmt”标签页下,焦点切换到"PERC H710 Mini"上按F2,然后"Foreign Config",再然后"Import",操作完成(要等待几秒)之后就能看到全部盘了,如图2所示。

PS:用Ctrl + N快捷键切换菜单标签。

发布时间:2024-10-18 16:35:44

-

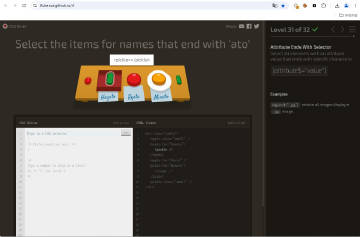

【经验分享】一个游戏闯关模式学习CSS Selector的网站"CSS Diner":https://flukeout.github.io/。

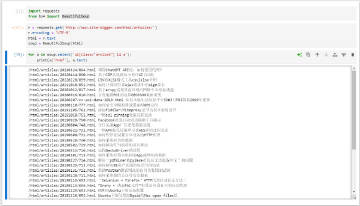

Python使用BeautifulSoup实现CSS Selector解析HTML文档的示例:

import requests

from bs4 import BeautifulSoup

r = requests.get('http://www.site-digger.com/html/articles/')

r.encoding = 'UTF-8'

html = r.text

soup = BeautifulSoup(html)

for a in soup.select('ul[class="arclist"] li a'):

print(a['href'], a.text)

发布时间:2024-09-02 19:43:03

-

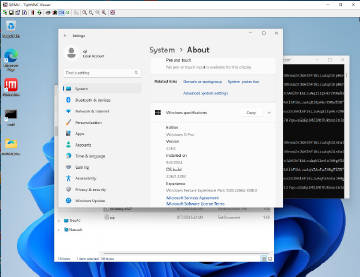

【经验分享】qemu-system-x86运行tiny11

(1) 安装qemu-system-x86,安装完成后无需重启。

sudo apt-get update

sudo apt-get install qemu qemu-utils qemu-system-x86

(2) 创建硬盘。

qemu-img create -f qcow2 tiny11.img 50G

(3) 创建虚拟机。

sudo qemu-system-x86_64 --enable-kvm -m 2G -smp 4 -boot order=dc -hda /home/qi/kvm/tiny11-1/tiny11.img -cdrom /home/qi/kvm/tiny11_23H2_x64.iso -vnc :1

(4) vnc连接 "服务器ip:5901",完成系统安装过程。设置vnc密码的方法:https://qemu-project.gitlab.io/qemu/system/vnc-security.html#with-passwords。

(5) 映射主机端口给虚拟机,使用-redir参数。如下示例,将主机的TCP/UDP4001端口映射到虚拟机的4000端口。

-redir tcp:4001::4000 -redir udp:4001::4000

发布时间:2024-08-10 12:13:46

-

【经验分享】Playwright过geo.captcha-delivery.com检测

page.add_init_script('''Object.defineProperties(navigator, {webdriver:{get:()=>undefined}}); delete navigator.__proto__.webdriver;''') 发布时间:2024-07-31 10:41:18

-

【经验分享】scrcpy在网络质量欠佳环境下可以通过降低码率来提高流畅度

e.g.

scrcpy --bit-rate 1M --max-fps 5

注意:在新版本中--bit-rate参数更名为--video-bit-rate 发布时间:2024-07-03 10:11:54

国内知名本地生活信息平台3648万商户数据2017年07月份更新

发布时间:2016-01-22

数据说明:

国内知名本地生活信息平台(你懂的)全国3648万商户(所有分类)数据2017年07月份更新。

PS:仅商户数据,不含评论列表数据。

有图有真相:

更新说明:

- 删除mall_id字段(网站改版,已无该信息);

- 删除history字段(网站改版,已无该信息);

- navigation字段更名为breadcrumb;

- 修复“家装类”由于模板升级造成的数据不全的问题;

详细字段说明:

- “shop_id"(商户ID,唯一、固定不变)

“mall_id"(商户所述商场的shop_id)(网站改版,已无该信息)

- “verified"(是否加V)

- "is_closed"(是否停业)

- "name"(商户名称)

- "alias"(别名)

- "province"(省)

- "real_city"(真实所属城市)

- "city"(市)

- "city_pinyin"(市拼音)

- "city_id"

- "area"(区)

- "big_cate"(一级分类)

- "big_cate_id"

- "small_cate"(二级分类)

- "small_cate_id"

- "address"(地址)

- "business_area"(商圈)

- "phone"(电话)

- "hours"(营业时间)

- "avg_price"(均价)

- "stars"(星级)

- "photos"(图片)

- "description"(描述)

- "tags"(标签)

- "map_type"

- "latitude"(纬度, 腾讯地图)

- "longitude"(经度, 腾讯地图)

- "breadcrumb"(导航栏、面包屑内容)

- "traffic"(交通)

- "characteristics"(特色)

- "product_rating"(口味/产品评分)

- "environment_rating"(环境评分)

- "service_rating"(服务评分)

- "all_remarks"(全部点评数)

- “default_remarks"(默认点评数)

- "very_good_remarks"(5星数)

- "good_remarks"(4星数)

- "common_remarks"(3星数)

- "bad_remarks"(2星数)

- "very_bad_remarks"(1星数)

- "recommended_dishes"(推荐菜)

- "recommended_products"(推荐产品)

- "parking"(停车位信息)

- "nearby_shops"(周边商户)

- "is_chains"(是否是连锁店)

- "take-away"(是否外卖)

- "group"(团购信息)

- "card"(会员卡)

- "latest_comment_date"(最新评论日期)

"history"(历史时间点:加入时间、更新时间、最后评论时间三类信息分号分隔)(网站改版,已无该信息)

- "visits_total"(总浏览数)

- "visits_month"(本月浏览数)

- "visits_week"(本周浏览数)

- "num_collected"(收藏人数)

示例数据:

- 定制示例数据

- 你可以联系我们在线客服获取你想要的部分示例数据,例如某个城市某个分类的示例数据。也可以查询验证某个条件对应的商户数量。

联系客服:

客服QQ:312602670 或 1649677458

客服电话:13389148466 或 13571845363

关于本数据的FAQ:

- 你们多久更新一次数据?

- 答:大概6个月更新一次。

- 你们完整采集一次需要要花多长时间?

- 答:一个月左右。我们每次都是全量采集,本次下载页面量超过1.5亿。

- 你们采集到的数据量为什么这么大,我自己采集为什么只能采集到几百万?

- 答:网站的列表页有页数限制。我们采用递归子分类和子区域,结合遍历shop_id的方式,最大程度上保证了数据的完整性。

- 我发现你们的数据缺失了某个店铺,是什么原因造成的?

- 答:这很正常,在采集开始到采集完成这一个月内又会新增很多的店铺,而这些店铺的数据肯定会漏掉。

- 我发现了一个Bug,你们能给处理吗?

- 答:在数据购买半个月内,如果该Bug的影响范围大于10%,我们将立即处理,并免费提供一份处理后的数据。如果该Bug的影响范围小于10%,我们不能立即处理,但会在下一个版本中进行修复。由于网站的模板种类很多,要兼顾各种特殊情况,我们也在不断的修复数据中存在的历史问题。

- 我想增加一个字段,可以吗?

- 答:抱歉不行,购买现成的数据不提供任何修改支持。如果你想自定义字段,建议申请定制采集服务(费用会远高于购买现成数据)。

- 数据总量有多大?这么大怎么传给我?

- 答:ZIP文件约4.3GB左右,解压后CSV文件约21GB左右。通过百度网盘共享(有提取密码)。

- 你们能否帮我将数据导入数据库?

- 答:抱歉,你需要自己完成导入的过程。可以参考我们的导入教程:

- SQL文件导入MySQL教程: http://www.site-digger.com/html/articles/20150921/101.html

- CSV文件导出MySQL教程: http://www.site-digger.com/html/articles/20120525/34.html

- 你们有历史数据吗?

- 答:有。请联系我们的客服QQ咨询详情。

- 你们可以采集其它网站的数据吗?

- 答:是的,任意公开网站的非隐私数据我们都可以采集,这里有部分我们之前采集的示例数据 >>> 点击进入数据超市。PS:我们不采集任何非法网站(例如,博彩、色情)的数据、也不会采用非法手段窃取后台数据。

特别说明:本文旨在技术交流,请勿将涉及的技术用于非法用途,否则一切后果自负。如果您觉得我们侵犯了您的合法权益,请联系我们予以处理。

☹ Disqus被Qiang了,之前所有的评论内容都看不到了。如果您有爬虫相关技术方面的问题,欢迎发到我们的问答平台:http://spider.site-digger.com/