更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

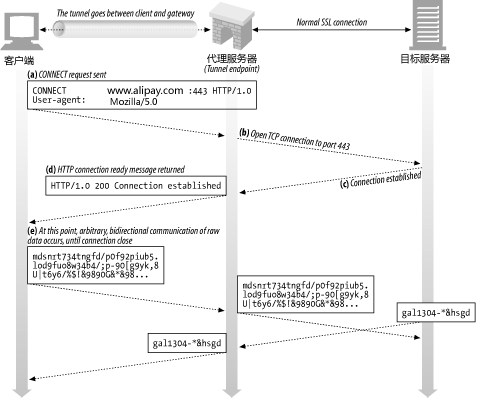

我们开展稳定高匿名HTTP代理业务以来,我听到客户咨询最多的问题之一就是“你们的代理支持HTTPS协议吗?”。我觉得很多人对HTTPS代理存在理解上的误区,所以我写了这篇文章。目的就是想说明“实现支持HTTPS的代理一点都不难!”。

说到HTTPS代理很多人瞬间就会联想到HTTPS的各种证书和各种加密,觉得很高端很复杂的样子。其实不然,代理服务器不需要配置证书、也不需要处理任何加密。因为HTTPS代理是通过Web隧道(Web tunnel)工作的。

Web隧道允许用户通过HTTP连接发送非HTTP流量(例如FTP,Telnet,SMTP),这就使得那些使用非HTTP协议的应用程序可以通过HTTP代理工作了。你现在应该就明白了为什么QQ可用设置使用HTTP代理工作。Web隧道这么强大,但它并不复杂。

Web隧道是用HTTP协议的CONNECT方法建立起来的。CONNECT方法不是HTTP/1.1核心规范的一部分,但确是一种得到广泛应用的扩展。客户端通过CONNECT方法请求代理服务器创建一条到达任意目的服务器和端口的TCP链接,代理服务器仅对客户端和服务器之间的后续数据进行盲转发(只是转发,不关心、也不懂发送的内容是什么)。

建立Web隧道的详细步骤如下:

1) 客户端通过HTTP协议发送一条CONNECT方法的请求给代理服务器,告知代理服务器需要连接的主机和端口。

例如:

CONNECT www.alipay.com:443 HTTP/1.1

User-agent: Mozilla/5.0

在本例中客户端通过CONNECT方法请求代理服务器打开一条到www.alipay.com主机443端口的TCP链接。

2) 代理服务器一旦建立了和目标主机(上例中的www.alipay.com:443)TCP连接,就会回送一条HTTP 200 Connection Established应答给客户端。

例如:

HTTP/1.1 200 Connection Established

Poryx-Agent: Squid/3.2

3) 此时隧道就建立起来了。客户端通过该HTTP隧道发送的所有数据都会被代理服务器(通过之前建立起来的与目标主机的TCP连接)原封不动的转发给目标服务器。目标服务器发送的所有数据也会被代理服务器原封不动的转发给客户端。注意:是原封不动的转发,代理服务器并不需要知道内容的含义,也不会尝试去对内容进行解析。

PS:上面这张插图是我引用《HTTP权威指南》一书的,做了修改。

这下你应该明白了Web隧道的工作原理。所以对代理服务器来说只要其支持Web隧道就支持HTTPS协议(和其它非HTTP协议),与证书、加密没有任何直接的关系。从上面的过程可以看出,实现Web隧道并不难,只要代理服务器能够正确处理CONNECT请求,然后对数据进行盲转发即可。从难度上看这比标准的HTTP协议代理还要简单(标准HTTP协议代理需要对客户端和服务端双方的HTTP报文先进行解析,修改后再进行转发)。

现在应用最广泛的HTTP代理软件非Squid莫属,Squid默认就是支持Web隧道的,详见Squid的文档:http://wiki.squid-cache.org/Features/HTTPS。因此Squid支持HTTPS也是天生的,无需做额外设置。我们的代理服务器软件使用的也是Squid,所以100%是支持HTTPS的。

顺便提一下,Squid默认只允许建立到目标端口为443(HTTPS的默认端口)的Web隧道。但我们可以通过设置SSL_Ports参数,使其允许更多的端口。一个我实际遇到的情况:访问一个端口为非443的HTTPS网站(9061), Squid会总是返回“urlopen error Tunnel connection failed: 403 Forbidden”的错误,在SSL_Ports中添加9061端口后就工作了。关于SSL_Ports的更多解释可以参考Squid的文档:http://wiki.squid-cache.org/SquidFaq/SecurityPitfalls#The_Safe_Ports_and_SSL_Ports_ACL

最后附上我用Wireshark抓取火狐浏览器通过HTTPS代理和支付宝的交互过程的报文,及部分报文片段:

补充内容:

一个带有权限认证的Web隧道建立过程如下(http://www.web-cache.com/Writings/Internet-Drafts/draft-luotonen-web-proxy-tunneling-01.txt):

CLIENT -> SERVER SERVER -> CLIENT

-------------------------------------- -----------------------------------

CONNECT home.netscape.com:443 HTTP/1.0

User-agent: Mozilla/4.0

<<< empty line >>>

HTTP/1.0 407 Proxy auth required

Proxy-agent: Netscape-Proxy/1.1

Proxy-authenticate: ...

<<< empty line >>>

CONNECT home.netscape.com:443 HTTP/1.0

User-agent: Mozilla/4.0

Proxy-authorization: ...

<<< empty line >>>

HTTP/1.0 200 Connection established

Proxy-agent: Netscape-Proxy/1.1

<<< empty line >>>

<<< data tunneling to both directions begins >>>