更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

对于有经验的技术人员来说导入大SQL文件到数据库中并没有什么难度,然而有很多客户本身不是做技术的,甚至从来没接触过MySQL,对他们来说这就是一件非常难的事。

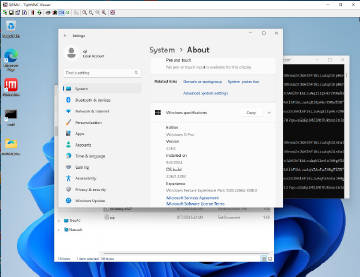

在本文中鲲之鹏的技术人员将给大家介绍在Windows平台上如何将一个含有约1500万条记录、文件大小超过8GB的SQL文件(之前通过mysqldump导出的)快速导入MySQL数据库。即使你之前没有任何经验,按照我们的步骤操作,一样可以顺利完成。

下文中用到的软件或工具的下载地址:链接: http://pan.baidu.com/s/1c0ExnBq 密码: akaq

假设那个大SQL文件放在d:/dianping_com.sql(后面会用到这个路径)。

1)安装MySQL Server。

如果你的电脑上已经安装过MySQL Server了,请跳过本步。

双击mysql-5.0.22-win32.exe,一路下一步,但其间有几个要注意的点:

a) “MySQL.com Sign-Up”界面时选择"Skip Sign-Up"即可。

b) “Wizard Completed”界面时选择“Configure the MySQL Server now”进入配置向导。

c) 勾选“Include Bin Directory in Windows PATH”。如下图所示。

d) “New root password/Confirm”是设置数据库root密码的地方,一点要牢记你设置的这个密码,后面会用到。如下图所示。

2)安装MySQL管理工具 - Navicat for MySQL 9。

Navicat for MySQL是一款功能非常强大的MySQL管理工具。

双击navicat9_mysql_cs.exe,一路下一步完成安装。

3)创建数据库。

打开Navicat,点击“连接”按钮创建一个MySQL Server的连接,只用输入root密码并点击确定按钮即可完成本地连接的建立,默认的名称是"localhost_3306"。

双击刚才建立的"localhost_3306"即可连接上MySQL数据库,点击鼠标右键“新建数据库”,输入一个你想用的数据库名称,选择字符编码为UTF-8,确定即可。如下图所示。

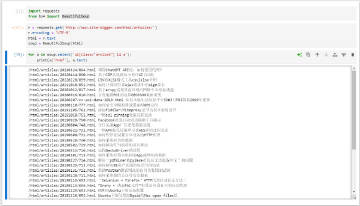

4)用MySQL的source命令导入SQL文件。

a) 进入CMD(在运行里输入cmd.exe)。

b) 执行mysql -uroot -p你在第一步设置的密码 进入MySQL命令提示符。

c) 依次执行如下MySQL命令(别漏掉结尾的分号):

use dianping_com;

set charset utf8;

source d:/dianping_com.sql;

等待执行完毕即可关闭窗口。

至此数据导入过程完毕。在4核4GB环境下导入用时约30分钟。